No mês passado, um bot de inteligência artificial que presta suporte técnico para o Cursor — uma ferramenta promissora voltada para programadores — alertou diversos clientes sobre uma mudança na política da empresa. Disse que eles não poderiam mais usar o Cursor em mais de um computador.

- Fim da escala 6×1: Alckmin vê ‘tendência mundial’ de redução de jornada de trabalho e defende debate

- INSS suspende antecipação salarial após denúncia de bancos de cobranças indevidas

Os Clientes reclamaram. Alguns cancelaram suas contas. E outros ficaram ainda mais irritados ao perceberem o que realmente havia acontecido: o bot de IA havia anunciado uma mudança de política que não existia.

“Não temos essa política. É claro que vocês podem usar o Cursor em várias máquinas”, escreveu Michael Truell, CEO e cofundador da empresa, em uma publicação no Reddit. “Infelizmente, essa foi uma resposta incorreta de um bot de suporte com IA.”

- Windsurf: OpenAI está próxima de comprar ferramenta de codificação com IA, por US$ 3 bi

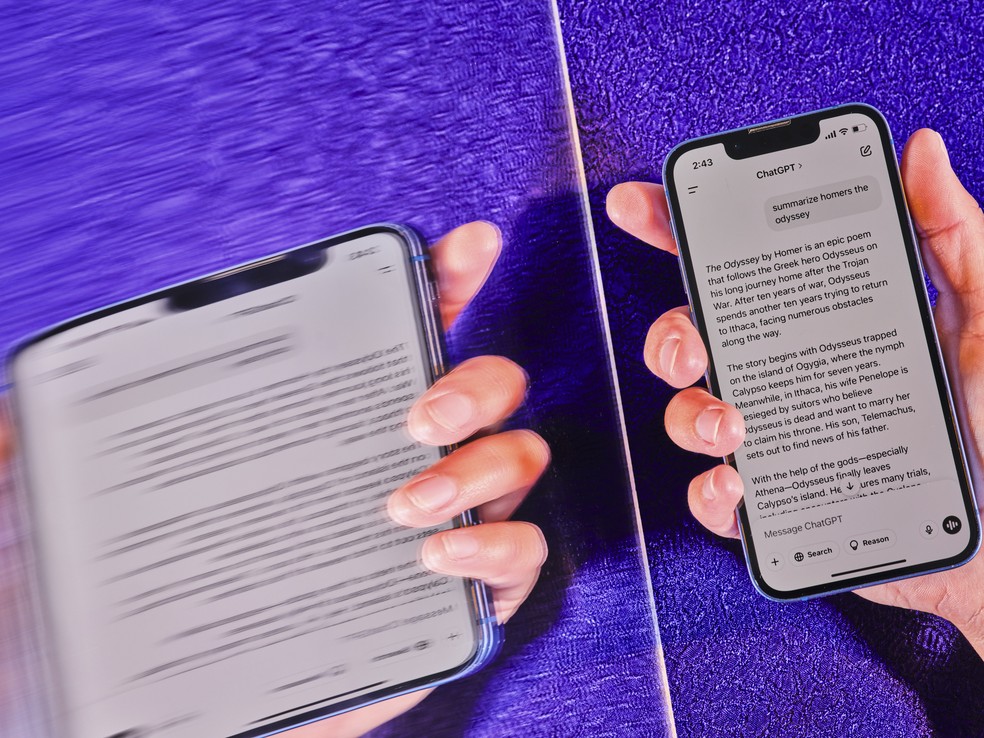

Mais de dois anos após o lançamento do ChatGPT, empresas de tecnologia, profissionais de escritório e consumidores comuns estão utilizando bots de IA para uma variedade cada vez maior de tarefas. No entanto, ainda não há uma forma de garantir que esses sistemas forneçam informações precisas.

As tecnologias mais novas e avançadas — os chamados sistemas de raciocínio — estão gerando mais erros, não menos. Embora suas habilidades matemáticas tenham melhorado significativamente, sua precisão em relação a fatos se tornou mais instável.

Os bots de IA atuais são baseados em sistemas matemáticos complexos que aprendem analisando enormes quantidades de dados digitais. Eles não conseguem — e nem podem — distinguir entre o que é verdadeiro e o que é falso.

- Sobrou até para a boneca: Fabricante da Barbie altera previsão de crescimento por causa do impacto das tarifas de Trump sobre brinquedos

Às vezes, simplesmente inventam coisas, um fenômeno que alguns pesquisadores chamam de “alucinações”. Em um dos testes, as taxas de alucinação dos sistemas de IA mais recentes chegaram a 79%.

Durante mais de dois anos, empresas como a OpenAI e o Google melhoraram gradualmente seus sistemas de IA e reduziram a frequência desses erros. No entanto, os sistemas mais recentes da OpenAI apresentaram taxas de alucinação mais altas do que o sistema anterior da empresa, segundo testes realizados pela própria companhia.

A empresa descobriu que o o3 — seu sistema mais poderoso — teve uma taxa de alucinação de 33% ao realizar o teste PersonQA, que envolve responder perguntas sobre figuras públicas. Isso é mais que o dobro da taxa de alucinação do sistema de raciocínio anterior da OpenAI, o o1. Já o novo o4-mini apresentou uma taxa ainda maior: 48%.

Em outro teste chamado SimpleQA, que faz perguntas mais gerais, as taxas de alucinação do o3 e do o4-mini foram de 51% e 79%, respectivamente. O sistema anterior, o1, alucinou em 44% das vezes.

Em um artigo detalhando os testes, a OpenAI afirmou que mais pesquisas são necessárias para entender a causa desses resultados.